Deep Network Compression based on Partial Least Squares

[/trx_title]

A revista Neurocomputing, da Elsevier, publica artigos descrevendo recentes contribuições fundamentais no campo da Neurocomputação. Na próxima edição, o trabalho do nosso membro Artur Jordão estará presente como uma das aplicação relevantes para essa área do conhecimento.

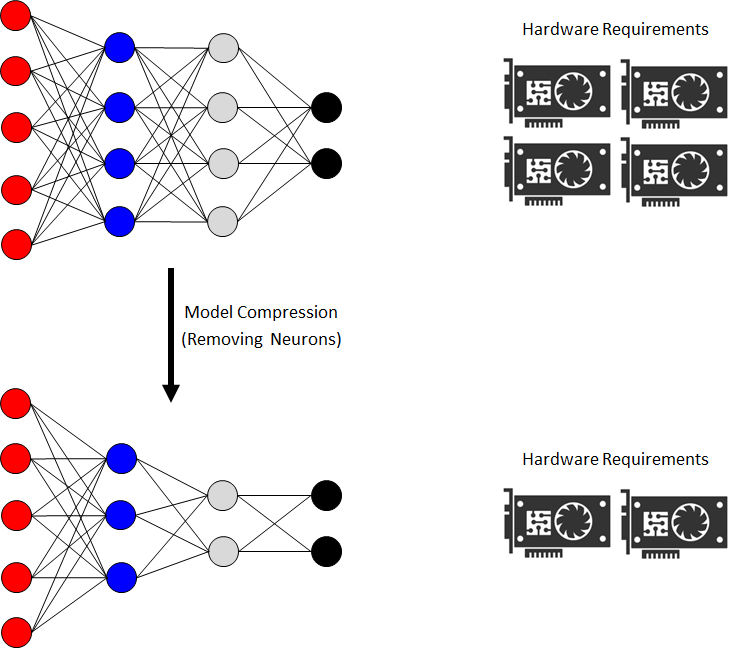

No contexto de inteligência artificial e aprendizagem de máquina, as Redes convolucionais tem proporcionado uma série de avanços em tarefas de visão computacional e processamento de linguagem natural. Entretanto, esses modelos requerem uma grande quantidade de processamento e memória, condicionando o seu uso em sistemas com recursos limitados.

Nesse trabalho, foi proposta uma nova estratégia que remove neurônios de redes convolucionais visando reduzir seu custo computacional enquanto preserva a sua habilidade de predição. A abordagem identifica de forma discriminativa e eficiente neurônios com baixa importância, de modo que sua remoção não afete (ou afete muito pouco) a precisão da rede. Esses neurônios são identificados utilizando a técnica de projeção de características Partial Least Squares, que é utilizado para modelar a relação entre os neurônios e a habilidade de predição da rede.

Os resultados mostram que redes computacionalmente proibitivas podem ser mais eficientes sem degradação em sua precisão. Comparado com outras técnicas no contexto de compressão e aceleração de redes convolucionais, nossa estratégia alcança resultados estado-da-arte e, na maioria das vezes, é significativamente mais eficiente.